Många har rapporterat om en märkbar försämring av kvaliteten i modellens svar, men det har hittills varit mest baserat på anekdotiska upplevelser.

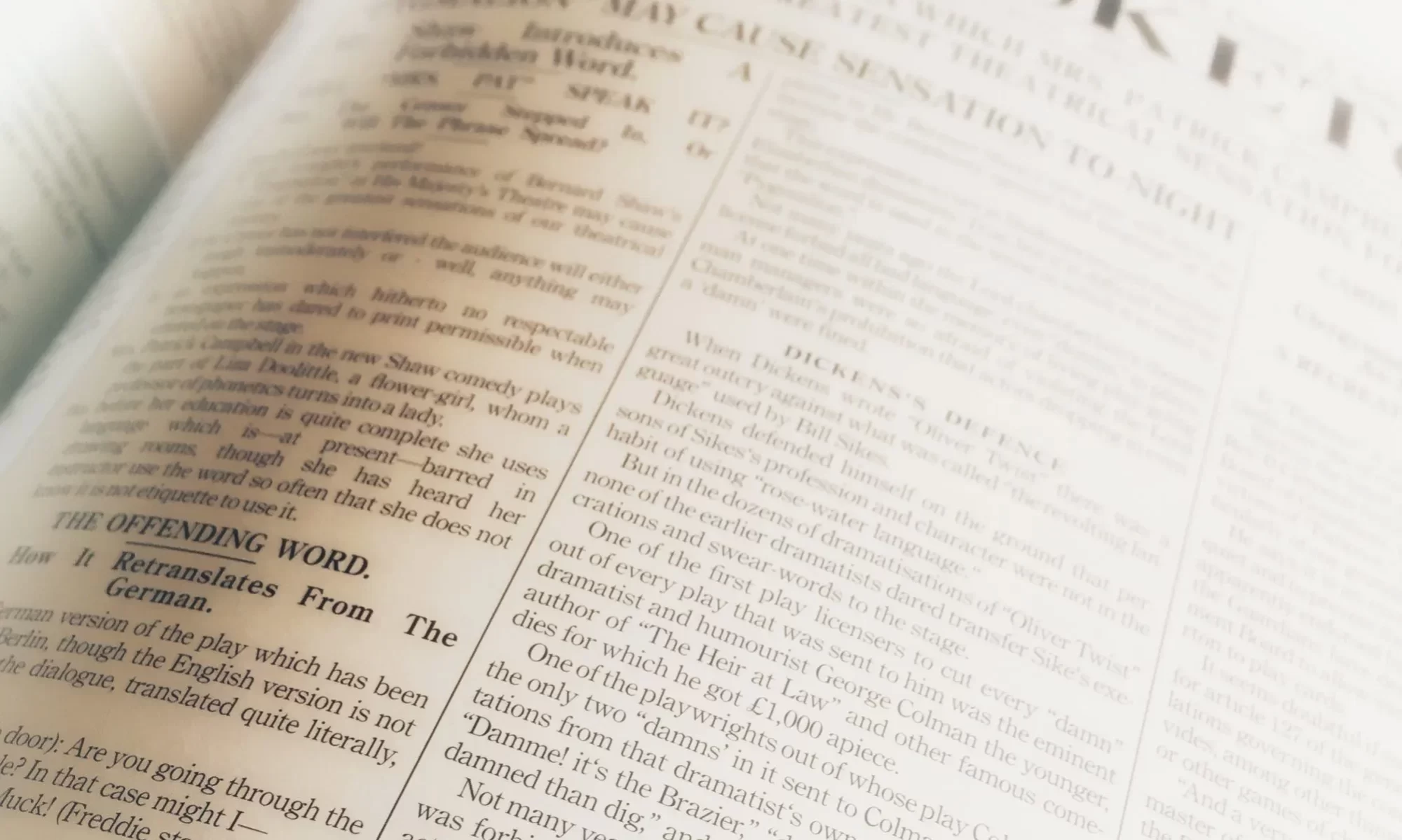

Men nu har vi fått in lite bättre belägg. Bild direkt hämtad från mitt LinkedIn-flöde.

En studie visar att GPT-4 i juni-versionen faktiskt är objektivt sämre än den versionen som släpptes i mars, åtminstone när det gäller vissa uppgifter. Forskningsteamet utvärderade modellerna med hjälp av en datamängd på 500 problem där modellerna skulle avgöra om ett givet heltal var ett primtal. I mars svarade GPT-4 korrekt på 488 av dessa frågor. I juni fick den bara 12 rätta svar.

Framgångsgraden sjönk från 97,6% till 2,4%!

Men det blir ännu värre! För att hjälpa modellen att resonera använde forskarna “Chain-of-Thought”:

“Är 17077 ett primtal? Tänk steg för steg.”

“Chain-of-Thought” är en populär teknik som normalt förbättrar svaren avsevärt. Men tyvärr genererade den senaste versionen av GPT-4 inte mellanstegen och svarade istället felaktigt med ett enkelt “Nej.”

Även kodgenereringen har försämrats.

Forskningsteamet skapade en datamängd med 50 enkla problem från LeetCode och mätte hur många GPT-4-svar som körde utan några ändringar.I mars-versionen lyckades den med 52% av problemen, men med modellen från juni sjönk framgångsgraden drastiskt till bara 10%.

Varför händer detta?

Det är inte helt känt. Åtminstone inte för folk utanför företaget OpenAI. Man tror att OpenAI kontinuerligt gör förändringar, men vi vet inte exakt hur processen fungerar och hur de utvärderar om modellerna blir bättre eller sämre. Enligt rykten använder de flera mindre och specialiserade GPT-4-modeller som agerar på ett liknande sätt som en stor modell, men är billigare att köra. När en användare ställer en fråga avgör systemet vilken modell som ska användas för att svara.

Detta kan vara både billigare och snabbare, men kanske är det också orsaken till försämringen i kvalitet enligt vissa bedömare.

Detta kan vara en varningsflagga för alla som bygger applikationer som förlitar sig på GPT-4. Att en modells beteende ändras över tiden är inte hållbart för professionella lösningar.